Apple plant iCloud-Fotos und iMessage-Fotos seiner Nutzer zu prüfen – CSAM

Apple hat angekündigt, im Zuge des Kampfes gegen Kinderpornografie die Fotos seiner Nutzer in der iCloud und möglicherweise auch auf den Geräten automatisch gegen Child Sexual Abuse Material (CSAM) abzugleichen. Im Falle mehrerer Treffer soll der Nutzer über das National Center for Missing and Exploited Children (NCMEC) bei den Behörden angezeigt werden. Das Netz läuft Sturm.

Hier werben? Hier klicken!

Apple hat in einem White Paper erklärt, wie die technische Vorgehensweise sein wird und welche Organisationen beteiligt sein werden.

Update 06.08.2021

Apple bestätigte heute gegenüber 9to5Mac, dass eine Ausweitung der CSAM-Erkennungsfunktion außerhalb der Vereinigten Staaten von Land zu Land abhängig von den lokalen Gesetzen und Vorschriften erfolgen wird. Das Unternehmen gab keinen konkreten Zeitplan an, wann oder ob es die CSAM-Erkennung auf weitere Länder ausweiten wird.

Der technische Ablauf

Die Bilder sollen mit der Datenbank des National Center for Missing and Exploited Children (NCMEC) abgeglichen werden. Dabei bedient man sich sogenannter Hash-Werte, also Prüfsummen. Prüfsummen werden typischerweise dazu verwendet, um zu plausibilisieren, dass zwei Datensätze übereinstimmen.

Apple nutzt allerdings eine eigene Methode namens „NeuroHash“, die laut dem White Paper nicht nur eindeutige Treffer, sondern auch „nahezu identische“ Aufnahmen finden können soll, die sich in Größe oder Kompression vom Original unterscheiden. Die NeuroHash-Überprüfung soll vor dem Upload in die iCloud stattfinden. Also auf dem Gerät.

Finden die Systeme einen Treffer, sollen die Bilder mit einem sogenannten „Safety Voucher“ markiert werden. Gibt es mehrere Treffer, kann Apple die Datei entschlüsseln. Im Nachgang werden die Dateien dann von Menschen abschließend geprüft. Ist das Ergebnis dieser Prüfung positiv, wird der Nutzeraccount gesperrt und das NCMEC informiert, das den Nutzer bei den Behörden meldet.

Von Apples Überwachung sind Fotos nur betroffen, wenn iCloud-Fotos auf dem iPhone, iPad oder Mac aktiviert ist.

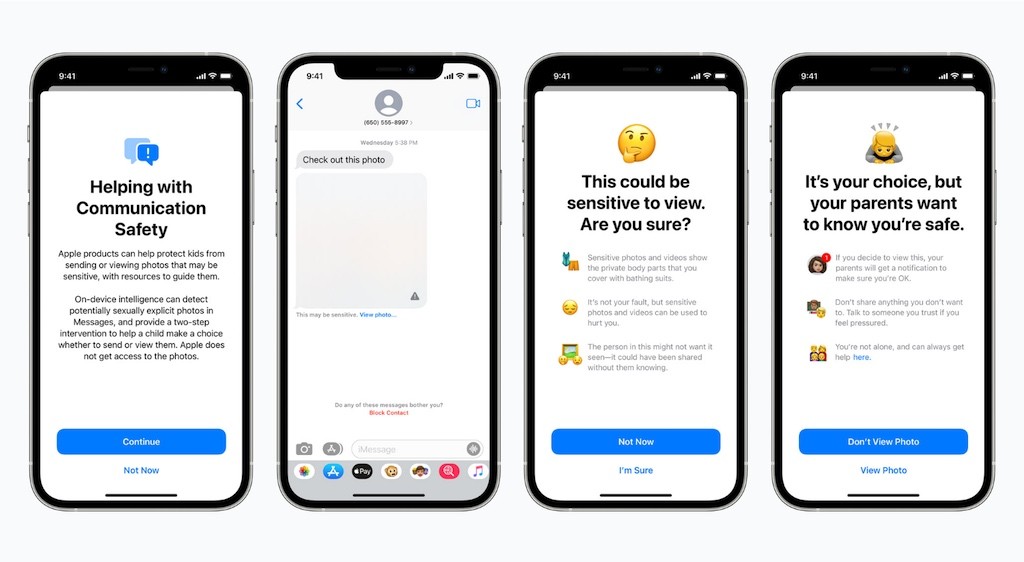

Außerdem plant Apple, auch Bilder auf anstößige Inhalte zu überprüfen, die mit iMessage versendet werden. Davon sind allerdings (angeblich) nur Kinder unter 13 Jahren betroffen. Eltern sollen benachrichtigt werden können, wenn verdächtige Bilder gesendet oder empfangen werden. Dafür muss die Option zur Kommunikationssicherheit für den Apple ID Account eines Kindes von einem Elternteil aktiviert werden.

Vorerst sollen die Neuerungen nur in den USA aktiviert werden, für andere Länder werden die Voraussetzungen geprüft.

Nutzer und Experten zeigen sich wenig begeistert

Das Netz ist bereits voll mit Nachrichten zu Apples neuen Plänen. Die Nutzerkommentare sind weitgehend verheerend. Was kein Wunder ist, wenn man die Sache zu ende denkt. Setzt Apple seine Pläne um, was bereits in iOS 15 der Fall sein soll, stehen praktisch alle Nutzer unter Generalverdacht. Zudem öffnen sich mit diesen Funktionen natürlich neue Tore für den Einfall von Schadsoftware und für den Missbrauch von Dritten.

Und wie kommt ein Unternehmen überhaupt dazu, sich als Internet-Polizei aufzuspielen? Und das auf Geräten, die ihnen gar nicht gehören? Die Frage, was als Nächstes kommt, muss man sich ebenfalls stellen dürfen. Wie sieht es in Ländern aus, in denen z. B. Homosexuelle verfolgt werden? Wie weit wird der Konsens mit einer solchen Regierung gehen? Wird der Schritt zur nächsten Überwachung durch Apples absurdes Vorgehen nicht um ein Vielfaches kleiner?

Ein paar Stimmen aus dem Netz:

Also ich muss sagen, ich bin üblich nicht unbedingt ein Aluhut-Träger. Aber bei der Vorstellung, jemand aus dem Apple-Team dringt aufgrund einer Software-Score in meine privatesten Fotos ein, um meine Gesetzestreue zu prüfen, ist wirklich außerhalb jeder Vorstellung. Da sind wir noch gar nicht beim Missbrauchspotenzial… einfach unfassbar, unerträglich und völlig inakzeptabel.

Nutzer kranzj, heise

Hier geht es nicht darum, dass sich jemand an deine Kinder „ran-wanzt“, das kann kein iPhone verhindern. Das ist genau die Art von Gehirnwäsche, die damals bei Zensursula schon versucht wurde. Hier wird der Schutz von Kindern vorgeschoben, um Überwachungsmaßnahmen zu etablieren.

Oliver Müller, Caschys Blog

Genau diese Art der Überprüfung stößt bei Sicherheitsexperten auf Kritik. So fürchtet Green in seinen Ausführungen zu Apple’s Plänen einen Missbrauch der neuen Infrastruktur, wie zum Beispiel das Scannen von Inhalten, die eigentlich per End-to-End-Verschlüsselung gesichert sind. Ähnliche Pläne hat kürzlich auch Facebook für seinen Messenger-Dienst Whatsapp gestartet.

Connect

Und zu guter Letzt kommentiert Security-Koryphäe Ross Anderson Apples neuesten Vorstoß: „Es ist eine absolut entsetzliche Idee, weil sie zu einer verteilten Massenüberwachung unserer Telefone und Laptops führen wird“.

Es bleibt abzuwarten, wie sich die Sache weiter entwickelt und welche Konsequenzen Nutzer daraus ziehen. Ich habe meine iCloud-Fotos jedenfalls umgehend abgeschaltet und synchronisiere Fotos nun über unsere NAS. Diese Möglichkeit hat natürlich nicht jeder, aber auch Dropbox bietet die Foto-Synchronisation an. Beides ist nicht ganz so elegant wie die iCloud, aber da sich mein Betriebssystem – nämlich iOS & Co. – offenbar zu einer Spyware entwickelt, ist dies die logische Konsequenz.

Bitte klick‘ hier und unterstütze unsere Arbeit mit einer Kaffeespende. Vielen Dank.

Geschrieben von Mick

Admin, apfel-affin, schreibsüchtig. Ich sende auf allen Frequenzen. Jeden Tag veröffentlichen mein Team und ich News, Trends und Infos. Wir freuen uns über Deinen Besuch.iMazing für Mac und Windows erkennt jetzt Pegasus-Spyware

outline Hochlumen LED Taschenlampe FL-304 – Review